ICU-Cockpit: Wenn Rechner die Intensivmedizin unterstützen

Autorin

Prof. Emanuela Keller

UniversitätsSpital Zürich

Ein einziger kritischer Patient, der auf einer Intensiv- oder Notfallstation behandelt wird, generiert bis zu 100 GB Daten pro Tag. Diese Informationsflut kann oft nicht für die rechtzeitige Erkennung von Risikokonstellationen und/oder Entscheidungsfindung durch das menschliche Gehirn integriert werden. Basierend auf «Data Mining», maschinellem Lernen und künstlicher Intelligenz können die enormen Mengen an Daten dazu verwendet werden, komplexe Zusammenhänge zu modellieren, um Algorithmen für Frühalarmsysteme und Therapieempfehlungen zu entwickeln.

Hintergrund: Die Halbwertszeit medizinischen Wissens beträgt wenige Jahre. Der Wissenszuwachs ist für Ärzte nicht mehr zu bewältigen. Zusätzlich nimmt in der «personalisierten Medizin» die Menge an vorhandenen Daten pro Patient exponentiell zu. In der Intensiv- und Notfallmedizin kommen neben klinischen, radiologischen und labormedizinischen Befunden noch Signale in Echtzeit von multiplen Sensoren des Monitorings im und am Körper hinzu. Die Datenmenge kann bis zu 100 GB pro Tag für ein einzelnes Individuum betragen. Dabei ist auch zu beachten, dass herkömmliche Monitoring-Systeme in der Lage sind, aufgrund einfacher Regeln, Alarme zu produzieren, wobei ein beträchtlicher Teil Artefakt induzierte Fehlalarme sind. Die Informationsflut kann – insbesondere in Notfallsituationen – nicht mehr zur raschen Entscheidungsfindung integriert werden.

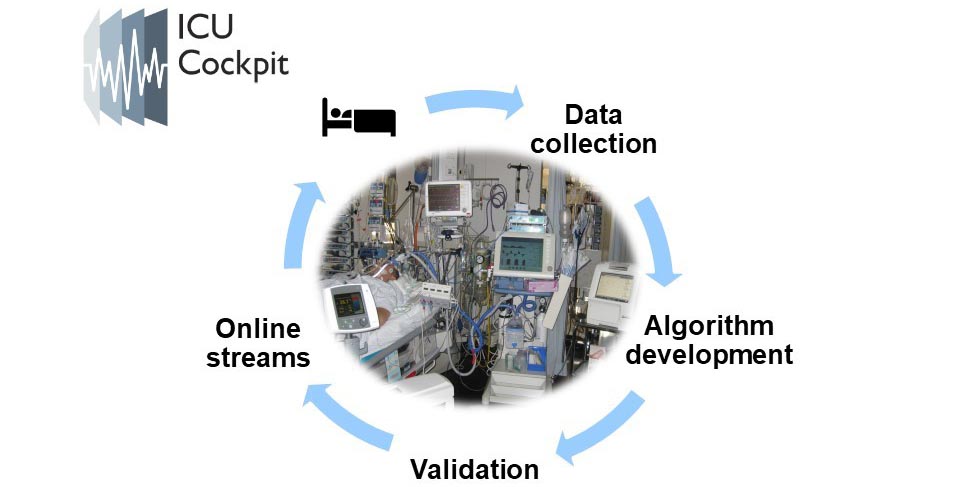

Methoden und Techniken: In der Neurochirurgischen Intensivstation des Universitätsspitals Zürichs wird seit 2014 in Kollaboration mit der ETH Zürich und IBM Research Rüschlikon das Projekt «ICU-Cockpit» realisiert. Dabei erfasst modernste Informationstechnologie die Daten zahlreicher medizintechnischer Geräte in Echtzeit und einer hohen Auflösung von bis mehreren hundert Hz. Klinische Metadaten wie Untersuchungsbefunde werden in verschlüsselter Form in einer eigens dafür entwickelten Software hinzugefügt. Eine Schnittstelle ermöglicht das Einlesen von Labordaten in Echtzeit. Mittels multivariabler Analyse sowie maschinellem Lernen werden Algorithmen entwickelt zum Ausfiltern von Fehlalarmen und zur Früherkennung von epileptischen Krampfanfällen und sekundären Hirnschädigungen.

Ziele: Eine Reduktion der – durch das Monitoring erzeugten – Fehlalarme durch die künstliche Intelligenz. Dadurch würde die Datenmenge reduziert und die Patientensicherheit erhöht werden. Durch das maschinelle Lernen wird sich das Mass der Reduktion laufend verbessern. Aus der laufenden multivariablen Datenstromanalyse in Echtzeit entstehen neue komplexe Erkenntnisse und neues Wissen. Dadurch werden Algorithmen geschaffen, die zur Erkennung von Risikokonstellationen führen und vor drohenden kritischen Ereignissen warnen, im Sinne einer Prognostik. Dadurch kann früher therapeutisch interveniert werden, was zu einer verbesserten Behandlungsqualität führt. Die künstliche Intelligenz unterstützt die medizinische Behandlung.